Pendahuluan

Di era digital yang serba cepat, data quality bukan lagi sekadar isu teknis, melainkan menjadi fondasi utama keberhasilan strategi bisnis, analitik, dan transformasi digital. Perusahaan kini bergantung pada data untuk setiap pengambilan keputusan, mulai dari menentukan arah pemasaran, mengoptimalkan operasional, hingga merancang inovasi produk. Namun, kenyataannya, kualitas data yang buruk dapat menjadi bumerang. Data yang tidak akurat atau tidak lengkap dapat menimbulkan resiko besar, seperti pengambilan keputusan yang keliru, pemborosan biaya operasional, peluang bisnis yang terlewat, hingga hilangnya kepercayaan pelanggan yang sudah dibangun bertahun-tahun.

Di tengah arus data yang terus membanjiri organisasi—baik yang terstruktur maupun tidak—tantangan menjaga kualitas data semakin kompleks. Kesalahan sekecil apa pun dalam proses pengumpulan atau pengolahan dapat berakibat domino yang merugikan. Karena itu, penerapan strategi end-to-end data quality menjadi sangat penting. Pendekatan ini memastikan bahwa setiap data yang dikumpulkan, diproses, disimpan, dan digunakan, memiliki akurasi, kelengkapan, konsistensi, ketepatan waktu, serta validitas yang terjaga di setiap tahap siklus hidupnya.

Artikel ini akan membahas secara detail bagaimana menjaga kualitas data dari hulu ke hilir melalui metode yang teruji, pemanfaatan tools modern, dan penerapan best practices yang telah terbukti berhasil di berbagai industri. Dengan memahami prinsip-prinsip ini, Anda tidak hanya dapat meminimalkan risiko yang timbul dari data buruk, tetapi juga mampu mengubah data menjadi aset strategis yang memberikan keunggulan kompetitif di pasar.

Mengapa Data Quality Penting untuk Bisnis

Kualitas data kini menjadi salah satu aset paling berharga dalam dunia bisnis modern. Ia menentukan keberhasilan analisis yang tepat sasaran, strategi pemasaran yang efektif, efisiensi operasional yang optimal, hingga inovasi berbasis teknologi yang mampu memenangkan persaingan. Tanpa data yang akurat, konsisten, dan relevan, semua upaya tersebut berisiko gagal sejak awal. Data yang keliru dapat membuat tim manajemen mengambil keputusan yang salah arah, memicu pemborosan sumber daya, hingga menimbulkan kerugian finansial yang signifikan.

Risiko ini bukan sekadar teori. Berbagai studi internasional menunjukkan bahwa poor data quality dapat merugikan organisasi hingga $15 juta per tahun, baik melalui hilangnya peluang bisnis, meningkatnya biaya operasional, maupun kerusakan reputasi. Dampak negatifnya bahkan bisa meluas ke hilangnya kepercayaan pelanggan, yang di era digital ini sulit untuk dibangun kembali.

Selain kerugian finansial, data yang tidak akurat juga dapat memperlambat inovasi. Perusahaan yang mengandalkan machine learning atau artificial intelligence misalnya, sangat membutuhkan data yang bersih dan konsisten sebagai bahan bakar model analisis. Jika kualitas data buruk, algoritma canggih sekalipun tidak akan mampu memberikan hasil yang optimal—garbage in, garbage out.

Oleh karena itu, investasi dalam end-to-end data quality bukanlah pilihan, melainkan kebutuhan strategis. Dengan memastikan kualitas data terjaga dari titik awal pengumpulan hingga digunakan untuk pengambilan keputusan, perusahaan dapat mengurangi risiko, menghemat biaya, dan menciptakan keunggulan kompetitif yang berkelanjutan.

Pendekatan End-to-End dalam Data Quality

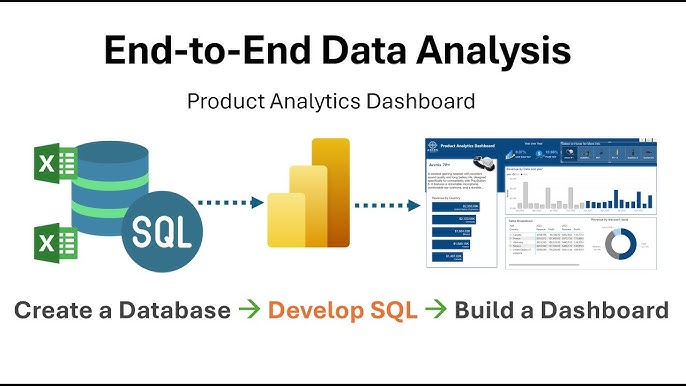

Pendekatan end-to-end data quality adalah strategi komprehensif yang memastikan kualitas data tetap terjaga di setiap tahap siklus hidupnya, mulai dari saat data dikumpulkan hingga akhirnya digunakan untuk pengambilan keputusan. Dengan memperhatikan setiap fase, risiko terjadinya kesalahan, inkonsistensi, atau kehilangan informasi dapat diminimalkan secara signifikan. Berikut empat tahap utama dalam pendekatan ini:

- Collection & Ingestion

Tahap awal ini merupakan pintu masuk seluruh data ke dalam sistem. Proses validasi dilakukan sejak data diterima, termasuk memeriksa kesesuaian skema, format, dan kelengkapan informasi yang dibutuhkan. Misalnya, memastikan semua kolom wajib diisi, format tanggal sesuai standar, dan data numerik berada dalam rentang nilai yang diizinkan. Validasi di tahap ini dapat mencegah masuknya data buruk (bad data) ke proses berikutnya. - Processing & Transformation

Setelah data terkumpul, tahap ini bertugas mengubah, membersihkan, dan menstandarisasi data agar siap digunakan. Proses meliputi standarisasi format (misalnya, penulisan alamat dan nama), penghapusan data duplikat (deduplication), serta penerapan aturan bisnis yang relevan. Validasi logika bisnis di tahap ini memastikan bahwa data tidak hanya akurat secara teknis, tetapi juga relevan secara kontekstual bagi kebutuhan bisnis. - Storage & Management

Pada fase ini, fokus bergeser ke bagaimana data disimpan, dikelola, dan dijaga integritasnya. Profiling data dilakukan untuk memahami karakteristik data secara menyeluruh, termasuk pola distribusi nilai dan potensi anomali. Integritas referensial antara tabel atau entitas dijaga dengan menerapkan constraints dan relasi yang konsisten. Pemantauan performa sistem penyimpanan juga penting untuk memastikan akses data tetap cepat dan andal. - Analytics & Consumption

Tahap akhir ini melibatkan pemanfaatan data untuk analisis, pelaporan, atau input ke dalam sistem AI. Validasi output dilakukan untuk memastikan hasil analisis sesuai dengan data sumber dan tujuan bisnis. Deteksi bias, verifikasi model analitik, dan pengujian hasil menjadi langkah penting di sini. Dengan demikian, keputusan yang diambil berdasarkan data benar-benar mencerminkan kondisi yang sebenarnya, bukan hasil dari data yang cacat.

Dengan menerapkan prinsip end-to-end data quality di setiap tahap ini, perusahaan dapat membangun fondasi data yang kokoh, meminimalkan risiko kesalahan, dan memastikan setiap keputusan yang diambil berbasis pada informasi yang akurat, lengkap, dan terpercaya.

Dimensi Utama Kualitas Data

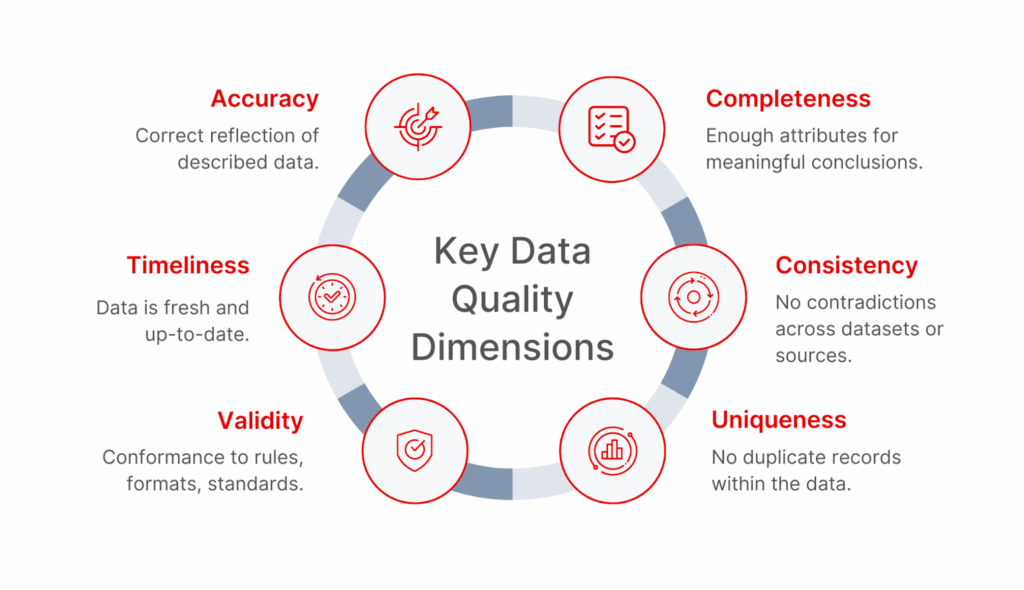

Untuk menjaga data quality secara menyeluruh, organisasi perlu memantau dan mengelola enam dimensi utama ini. Setiap dimensi memiliki peran penting dalam memastikan data dapat diandalkan untuk analisis, pengambilan keputusan, maupun pemrosesan lanjutan.

- Accuracy (Akurasi)

Akurasi mengacu pada sejauh mana data merepresentasikan kondisi sebenarnya di dunia nyata. Data yang akurat bebas dari kesalahan faktual dan sesuai dengan sumber aslinya. Contoh: alamat pelanggan di database harus sesuai dengan alamat aktual yang digunakan pelanggan. Kesalahan pada dimensi ini dapat menyebabkan keputusan yang salah dan berdampak langsung pada operasional bisnis. - Completeness (Kelengkapan)

Kelengkapan memastikan bahwa semua informasi yang dibutuhkan tersedia di dalam dataset. Data yang tidak lengkap bisa menghambat analisis dan menyebabkan kesimpulan yang bias. Misalnya, jika kolom “tanggal lahir” dalam data pelanggan kosong untuk sebagian besar entri, analisis demografi menjadi tidak valid. - Consistency (Konsistensi)

Konsistensi berarti data memiliki format, nilai, dan arti yang sama di seluruh sistem dan sumber data. Inkonsistensi sering muncul saat data berasal dari berbagai platform atau proses integrasi yang buruk. Contoh: satu sistem menyimpan status “Aktif” sedangkan sistem lain mencatat “Active” untuk entitas yang sama. Standarisasi format dan kode diperlukan untuk mengatasi masalah ini. - Timeliness (Ketepatan Waktu)

Data harus tersedia tepat waktu sesuai kebutuhan bisnis atau operasional. Informasi yang terlambat dapat mengurangi nilai dan relevansinya. Misalnya, data penjualan yang baru diperbarui seminggu kemudian akan kurang bermanfaat untuk keputusan harga harian. Proses pembaruan data secara real-time atau periodik menjadi kunci menjaga dimensi ini. - Validity (Validitas)

Validitas berkaitan dengan kepatuhan data terhadap aturan bisnis dan format yang telah ditetapkan. Data yang valid mengikuti business rules seperti format nomor telepon, struktur kode produk, atau rentang nilai yang diizinkan. Misalnya, sistem seharusnya menolak input nilai negatif untuk kolom “jumlah stok” jika aturan bisnis melarangnya. - Uniqueness (Keunikan)

Keunikan memastikan tidak ada duplikasi yang tidak diinginkan dalam dataset. Duplikasi dapat menyebabkan kebingungan, pelaporan ganda, dan pengambilan keputusan yang keliru. Contoh: satu pelanggan yang sama terdaftar dua kali dengan ID berbeda, mengakibatkan analisis perilaku pelanggan menjadi terdistorsi.

Dengan memantau keenam dimensi ini secara berkelanjutan, organisasi dapat membangun kerangka kerja end-to-end data quality yang kokoh, mengurangi risiko kesalahan, dan memaksimalkan nilai bisnis dari data yang dimiliki.

Framework dan Tools Pendukung

Menjaga kualitas data dari hulu ke hilir memerlukan panduan metodologis (framework) dan dukungan teknologi yang tepat. Framework membantu merancang strategi dan proses kerja yang sistematis, sementara tools mempermudah eksekusi dan otomasi pengecekan kualitas data.

Framework yang Umum Digunakan

- DAMA-DMBOK (Data Management Body of Knowledge)

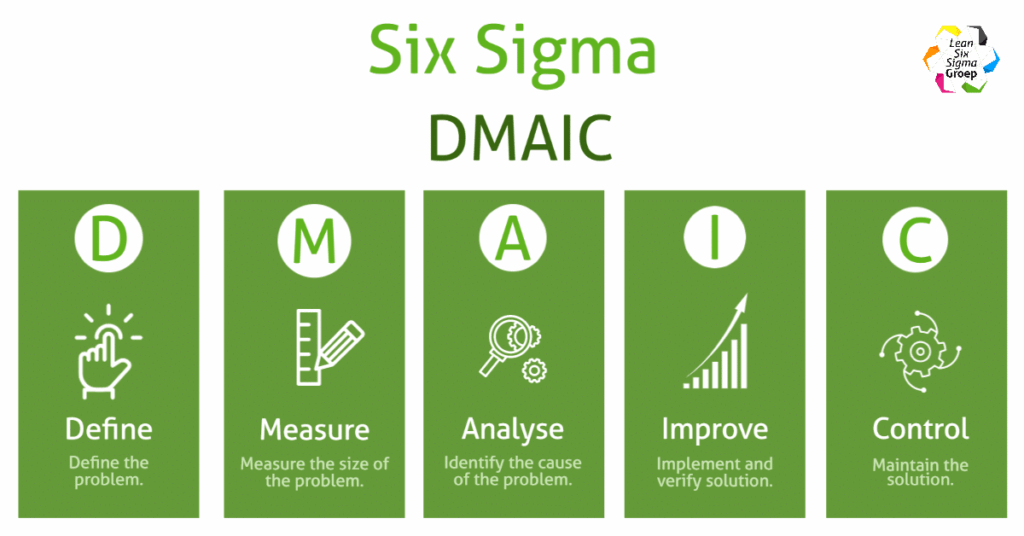

Merupakan kerangka referensi internasional untuk pengelolaan data. DAMA-DMBOK mencakup panduan lengkap mulai dari tata kelola data, manajemen kualitas, integrasi, hingga keamanan. Pendekatan ini cocok bagi organisasi yang ingin memiliki governance yang kuat. - Six Sigma DMAIC

Metodologi peningkatan kualitas berbasis data yang terdiri dari lima tahap: Define, Measure, Analyze, Improve, dan Control. Pendekatan ini membantu tim QA mengidentifikasi sumber masalah kualitas data, mengukur dampaknya, dan mengimplementasikan solusi berkelanjutan. - Data Quality Maturity Model (DQMM)

Model ini mengukur tingkat kematangan pengelolaan kualitas data di sebuah organisasi. Mulai dari level awal (ad-hoc) hingga level tertinggi (optimized), framework ini memandu roadmap peningkatan kualitas data secara bertahap.

Tools Open Source

- Great Expectations

Sebuah framework open-source yang memungkinkan pengguna menulis tes validasi data secara deklaratif. Cocok digunakan untuk memverifikasi format, nilai, dan aturan bisnis sebelum data digunakan untuk analisis. - Apache Griffin

Platform open-source yang menyediakan solusi pengukuran dan pemantauan kualitas data secara real-time. Terintegrasi dengan ekosistem big data seperti Apache Spark dan Hadoop.

Tools Enterprise

- Monte Carlo

Platform Data Observability yang memantau aliran data dari hulu ke hilir, mendeteksi anomali, dan memberikan peringatan dini ketika terjadi masalah kualitas data. - Data Fold

Alat untuk membandingkan dataset secara otomatis, sangat bermanfaat untuk QA sebelum dan sesudah proses transformasi data (data pipeline changes).

Cloud-native Tools

- AWS Glue DataBrew

Layanan AWS yang memudahkan pembersihan (cleaning) dan transformasi data tanpa perlu menulis kode. Dilengkapi dengan ratusan fungsi pra-bangun untuk validasi dan standarisasi. - Google Cloud Dataprep

Layanan Google Cloud berbasis Trifacta yang memungkinkan data wrangling interaktif dengan antarmuka visual. Cocok untuk pengguna non-teknis yang ingin membersihkan data sebelum analisis.

Monitoring dan Perbaikan Berkelanjutan

Menjaga kualitas data tidak cukup hanya dilakukan di awal proses. Diperlukan sistem pemantauan dan perbaikan berkelanjutan yang mampu mengidentifikasi masalah lebih cepat, mencegah kerusakan data, dan memastikan kualitas tetap terjaga seiring waktu.

1. Real-time Dashboards dengan Grafana

- Gunakan Grafana untuk menampilkan data quality metrics secara real-time.

- Integrasikan dengan sumber data seperti Prometheus, Elasticsearch, atau API internal untuk memantau indikator penting seperti data freshness, error rate, dan missing values.

- Dashboard yang interaktif membantu tim QA, data engineer, dan manajemen melihat kondisi kualitas data secara langsung tanpa harus menunggu laporan manual.

2. Automated Alerting untuk Deteksi Penurunan Kualitas

- Terapkan sistem peringatan otomatis menggunakan tools seperti Grafana Alerting, PagerDuty, atau Opsgenie.

- Atur threshold yang memicu notifikasi jika terjadi penurunan kualitas, misalnya persentase null values di atas 5%, atau waktu update data yang melebihi SLA.

- Dengan alert otomatis, tim dapat langsung melakukan root cause analysis begitu masalah terdeteksi.

3. Quality Metrics Tracking untuk Evaluasi Periodik

- Tentukan metrik kualitas data yang menjadi tolok ukur, misalnya accuracy, completeness, timeliness, dan consistency.

- Lakukan pengukuran berkala, misalnya harian atau mingguan, untuk melihat tren peningkatan atau penurunan kualitas data.

- Dokumentasikan hasil evaluasi ini untuk keperluan audit, peningkatan proses, dan pembelajaran tim.

4. Continuous Improvement Loop

- Terapkan siklus PDCA (Plan – Do – Check – Act) untuk perbaikan berkelanjutan.

- Setiap temuan masalah harus diinvestigasi, diberikan solusi, diuji ulang, dan diintegrasikan ke dalam proses agar tidak terulang.

- Libatkan semua pemangku kepentingan—mulai dari tim QA, data engineering, hingga business analyst—dalam forum retrospective bulanan untuk membahas perbaikan kualitas data.

Kunci Sukses Implementasi Data Quality

Keberhasilan penerapan data quality tidak hanya bergantung pada teknologi yang digunakan, tetapi juga pada bagaimana organisasi mengelola proses, aturan, dan keterlibatan seluruh pihak yang terlibat. Ada tiga pilar utama yang menjadi kunci sukses:

1. Governance & Organization

- Dokumentasi Aturan Data

- Buat data governance framework yang mendefinisikan standar, kebijakan, dan prosedur terkait data.

- Sertakan definisi data ownership yang jelas, siapa yang bertanggung jawab untuk tiap set data.

- Monitoring Kontinu

- Pastikan ada proses pemantauan yang konsisten, baik melalui dashboard real-time maupun evaluasi berkala.

- Gunakan data stewardship untuk mengawasi kualitas data dari hulu ke hilir.

2. Technical Implementation

- Otomatisasi Validasi Data

- Implementasikan data validation pipeline yang secara otomatis memeriksa schema, data type, null values, dan business rules.

- Gunakan tools seperti Great Expectations, Monte Carlo, atau AWS Glue DataBrew untuk mempercepat proses validasi.

- Integrasi ke CI/CD

- Masukkan langkah validasi data ke dalam continuous integration & deployment pipeline, sehingga data yang masuk ke produksi selalu terverifikasi kualitasnya.

3. Business Integration

- Keterlibatan Pemangku Kepentingan

- Libatkan tim bisnis, marketing, operasional, dan analitik dalam proses perencanaan kualitas data.

- Pastikan kebutuhan data mereka tercermin dalam aturan validasi dan pelaporan.

- Membangun Budaya Data-Driven

- Edukasi seluruh tim tentang pentingnya kualitas data melalui training dan workshop.

- Dorong pengambilan keputusan berbasis data yang telah terverifikasi kualitasnya.

Kesimpulan

Menjaga kualitas data bukan sekadar tanggung jawab teknis tim IT atau QA, melainkan bagian dari strategi bisnis yang menentukan daya saing perusahaan di era digital. Data yang akurat, lengkap, konsisten, tepat waktu, valid, dan unik menjadi fondasi utama bagi keberhasilan analisis, pengambilan keputusan, serta inovasi berbasis data.

Dengan menerapkan pendekatan end-to-end data quality, organisasi dapat memastikan bahwa setiap tahap dalam siklus hidup data—mulai dari pengumpulan, pemrosesan, penyimpanan, hingga pemanfaatannya—berjalan sesuai standar yang ditetapkan. Hal ini tidak hanya meningkatkan akurasi analisis dan efektivitas strategi bisnis, tetapi juga mengoptimalkan efisiensi operasional, meminimalkan risiko, dan memperkuat kepercayaan pelanggan.

Perusahaan yang konsisten mengelola kualitas datanya akan lebih siap menghadapi tantangan pasar, lebih cepat beradaptasi terhadap perubahan, dan mampu menciptakan keunggulan kompetitif yang berkelanjutan.

Jika Anda ingin membangun proses data quality yang handal, terukur, dan sesuai dengan kebutuhan bisnis, Badr Interactive siap menjadi mitra strategis Anda—mulai dari perancangan arsitektur data, implementasi teknologi validasi, hingga integrasi monitoring kualitas data secara berkelanjutan.

FAQ

Tidak. Semua organisasi, baik besar maupun kecil, yang bergantung pada data untuk menjalankan operasional, analisis, atau pengambilan keputusan memerlukan proses data quality. Bahkan untuk UMKM, data yang akurat dapat menjadi pembeda signifikan dalam memahami pasar, mengelola stok, hingga menentukan strategi pemasaran.

Idealnya monitoring dilakukan secara real-time untuk data kritis seperti transaksi keuangan atau data operasional utama. Untuk data yang sifatnya batch atau laporan periodik, monitoring dapat dilakukan harian atau mingguan. Frekuensi ini harus disesuaikan dengan kebutuhan bisnis, risiko kesalahan, dan volume data yang dikelola.

Sebagian besar proses dapat diotomatisasi, seperti validasi format, pengecekan duplikasi, hingga deteksi nilai outlier. Namun, interpretasi hasil dan pengambilan keputusan perbaikan sering kali masih memerlukan intervensi manusia, terutama untuk konteks bisnis yang kompleks atau ketika menghadapi data yang ambigu.

Mengabaikan data quality dapat berdampak pada keputusan bisnis yang keliru, kerugian finansial, gangguan operasional, bahkan hilangnya kepercayaan pelanggan. Dalam jangka panjang, hal ini bisa menurunkan daya saing perusahaan di pasar.

Mulailah dengan data profiling untuk memahami kondisi data saat ini, kemudian susun framework data governance yang mencakup standar, kebijakan, dan proses validasi. Setelah itu, pilih tools yang sesuai dan mulai implementasi secara bertahap dengan fokus pada data yang paling kritis bagi bisnis.